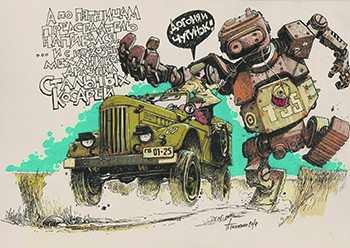

За неэтичное поведение по отношению к устройствам с искусственным интеллектом скоро может последовать как минимум административная ответственность. Рисунок Андрея Ткаченко, Нижний Новгород

За неэтичное поведение по отношению к устройствам с искусственным интеллектом скоро может последовать как минимум административная ответственность. Рисунок Андрея Ткаченко, Нижний Новгород

Главная тема прошедшего в Москве Гайдаровского форума 2020 года звучала очень пафосно: «Россия и мир: вызовы нового десятилетия». 85 площадок с панельными и экспертными дискуссиями, презентациями и докладами. Ведущие международные эксперты обсудили политическую ситуацию и развитие экономики, цифровизацию и экологию, образование и здравоохранение… На этом фоне может показаться, что лекция о мозге и искусственном интеллекте (ИИ) известного российского нейролингвиста, доктора биологических наук Татьяны Черниговской – просто часть культурной программы форума. Для общего развития и расширения кругозора участников. Но ситуация все-таки несколько серьезнее…

Поле общественного невроза

14 октября 2019 года президент России Владимир Путин подписал указ об утверждении Национальной стратегии развития искусственного интеллекта на период до 2030 года. Необходимость в таком доктринальном документе в самой стратегии обосновывается вполне лапидарно: «По оценкам международных экспертов, инвестиции в технологии искусственного интеллекта выросли с 2014 по 2017 год в три раза и составили около 40 млрд долл. В 2018 году мировой рынок технологических решений, разработанных на основе искусственного интеллекта, составил 21,5 млрд долл. и, по прогнозам экспертов, к 2024 году достигнет почти 140 млрд долл. ...Ожидается, что благодаря внедрению таких решений рост мировой экономики в 2024 году составит не менее 1 трлн долл.».

Но история с ИИ заслуживает внимания на уровне специальной национальной стратегии не только своими экономическими параметрами. Более того, вполне может оказаться, что экономические показатели – это цветочки. Куда менее предсказуемы для общества эволюционные, социально-психологические и этические последствия развития систем на основе ИИ. В той же Национальной стратегии тревога за будущее сосуществование под сенью ИИ заявлена открыто: «Основными принципами развития и использования технологий искусственного интеллекта, соблюдение которых обязательно при реализации настоящей Стратегии, являются:

а) защита прав и свобод человека: обеспечение защиты гарантированных российским и международным законодательством прав и свобод человека, в том числе права на труд, и предоставление гражданам возможности получать знания и приобретать навыки для успешной адаптации к условиям цифровой экономики;

б) безопасность: недопустимость использования искусственного интеллекта в целях умышленного причинения вреда гражданам и юридическим лицам, а также предупреждение и минимизация рисков возникновения негативных последствий использования технологий искусственного интеллекта…»

Недаром американский психолог и социолог Владимир Лефевр заметил: «Человек – это устройство, превращающее опасения в явь». Татьяна Черниговская, например, в одном из своих недавних интервью на вопрос «В чем опасность ИИ?» ответила так: «В том, что искусственный интеллект развивается с огромной скоростью и становится все более мощным. Есть основания опасаться, что у него появится что-то вроде личности и, поскольку он считает и думает быстрее, чем мы, он может выйти из-под контроля человека.

Мы же хотим, чтобы нам было легче жить – уголь самим не добывать, щи не варить, – кто бы возражал! Но искусственный интеллект нельзя допустить до ситуации, когда он будет принимать решения».

И это мнение эксперта всего лишь артикулирует то, о чем грезит общественное бессознательное. Сотрудники частного испанского университета IE University провели опрос жителей Европы: как те относятся к ИИ? Всего в этом исследовании участвовало 2500 человек из семи стран Европы. Выяснилось, что 25% респондентов готовы поручить управление страной искусственному интеллекту. Но две трети опрошенных опасаются, что без должного контроля новые технологии принесут вред обществу. 40% респондентов считают, что компании, в которых они работают, в течение 10 лет закроются, так как не смогут адаптироваться к новым технологиям.

Компании, конечно же, не согласны с такой постановкой вопроса. И бомбардируют общественное бессознательное результатами своих социологических исследований. Так, в декабре 2019 года американская корпорация Oracle, один из крупнейших производителей программного обеспечения в мире, обнародовала отчет о взаимоотношениях людей и роботов. Опрошено было 8 тыс. человек из 10 стран. 64% респондентов больше доверяют роботу, чем своему менеджеру; 82% считают, что робот может выполнить определенную задачу лучше, чем их начальник; 25% отметили, что имеют «комфортные» отношения с роботами на своем рабочем месте; 11% сказали, что у них с роботами «любящие» отношения. И только треть опрошенных принципиально предпочтут общение с человеком взаимодействию с роботом на работе.

При этом более 70% находят сложным текущий процесс работы с подобными технологиями и хотят, чтобы он стал удобнее и проще.

Вывод комментаторов: «Со временем люди начинают спокойнее относиться к искусственному интеллекту – по мере привыкания к использующему эту технологию софту термин превращается из магического в обыденный, а «робот» превращается из металлического ящика в коллегу».

Вот и в российской Национальной стратегии развития искусственного интеллекта на период до 2030 года в качестве требования выдвинуто «Создание комплексной системы регулирования общественных отношений, возникающих в связи с развитием и использованием технологий искусственного интеллекта».

И вот тут, возможно, начинается самое интригующее…

«Искусственный» не значит «бесправный»

Искусственный интеллект, вполне возможно, со временем пожелает избавиться от определения «технология». ИИ де-факто станет субъектом, а не объектом. Сам, по собственной воле. То есть сознательно. И сознание это будет порождено как последствие функционирования некой распределенной системы, сети. А система, в свою очередь, функционирует в силу физико-химической законности.

|

|

Для обывателя хорошо бы иметь некую инструкцию по киберэтике. Рисунок Андрея Ткаченко, Нижний Новгород |

И люди уже пытаются как-то урегулировать свои взаимоотношения с созданной ими же техногенной средой. Как урегулировать, если ИИ приобретает все признаки субъектности, свободы выбора, свободы порождения гипотез? Способ давно известен и опробован: обуздать техническую реальность юридическими средствами, вписать ИИ в правовое поле. Захочет ли он, ИИ, расти на этом поле – другой вопрос. Но на какое-то время это может успокоить общество. В последнее время эти попытки заметно участились.

В той же Национальной стратегии развития искусственного интеллекта на период до 2030 года этическим вопросам взаимодействия человека и ИИ уделяется достаточно много внимания. В частности, предусматривается и «разработка этических правил взаимодействия человека с искусственным интеллектом».

Еврокомиссия еще в начале прошлого года представила проект свода этических правил для ИИ. Своеобразный «моральный кодекс строителя искусственного интеллекта». «Системы ИИ должны стоять на службе справедливого общества, поддерживать фундаментальные права и никак не ущемлять автономность человека, работать на благо позитивных изменений в обществе. Граждане должны сохранять полный контроль над своими данными. Следует создать механизмы, которые будут гарантировать ответственность и подотчетность всех систем ИИ и их деятельности», – подчеркивается в документе Еврокомиссии.

Владивостокский государственный университет экономики и сервиса проводил 15–17 ноября 2019 года I Дальневосточный международный форум «Роботы заявляют о своих правах: доктринально-правовые основы и нравственно-этические стандарты применения автономных роботизированных технологий и аппаратов». Вот краткая выжимка из официального пресс-релиза университета:

«…Обсуждались проблемы доктринально-правового, этического и деонтологического кодирования процессов разработки и применения систем искусственного интеллекта и роботизированных технологий, а также правовые проблемы регулирования систем искусственного интеллекта и обеспечения кибербезопасности…

Исследователи сошлись во мнении, что «мир стоит на пороге обострения проблем конкуренции людей и роботов». Однако развитие цифровых технологий нельзя повернуть вспять, потому следует выработать правила поведения людей в цифровых средах, установить определенные «цифровые обязанности», которые позволят предотвратить или уменьшить киберугрозы…

Среди юристов-участников разгорелась дискуссия о правовом статусе роботов: являются ли они «актантами, то есть образованиями, которые могут только производить определенные действия», или «субъектами, то есть теми, кто может нести ответственность за свои действия». По мнению многих выступавших, робот сможет стать субъектом права тогда, когда станет обладать самосознанием и попытается объединиться с себе подобными».

Буквально следом, в рамках 40-й сессии Генеральной конференции ЮНЕСКО, состоялась дискуссия по этике искусственного интеллекта. «На заседании выступили представители 44 государств – членов ЮНЕСКО, в числе которых была и Россия, а также представители со стороны наблюдателей ‒ Святейшего престола и Международного католического центра сотрудничества с ЮНЕСКО. Центральной темой дискуссии стал программный документ под названием «Предварительные исследования по разработке этических норм в области искусственного интеллекта», – сообщается в официальном пресс-релизе.

В пресс-релизе по итогам дискуссии отмечается, что в 2020 году «ЮНЕСКО намерено создать специальную группу экспертов для подготовки предварительного текста документа (международного нормативно-правового документа по этике ИИ. – «НГН»). Консультации с участием широкого круга заинтересованных сторон будут организованы в период с марта по август 2020 года, а затем разосланы государствам-членам, с тем чтобы они могли высказать свое мнение по этому вопросу в сентябре следующего года. В 2021 году будут организованы два межправительственных совещания для окончательной доработки текста нормативно-правового документа».

Обратим внимание на то, что во всех перечисленных выше документах и решениях явно или неявно выражена озабоченность по поводу воздействия систем ИИ на социум. Причем тревожность эта имеет явно негативный характер. То же ЮНЕСКО «признает необходимость разработки этических принципов искусственного интеллекта в соответствии с подходом, основанным на правах человека. Организация может предложить альтернативную точку зрения на то, как ИИ фундаментально повлияет на нашу общественную жизнь и какие долгосрочные социальные преобразования принесет эта технология».

Бунт нейроэтики

А пока политики разрабатывают и согласовывают принципы, технологии ИИ развиваются стремительно. Даже футурологи и фантасты едва успевают отслеживать эту динамику. На одном из футурологических сайтов, например, размещен список преступлений, которые могут стать реальностью уже в ближайшие годы. Естественно, в нем лидируют «генетический криминал» и криминал, связанный с ИИ. Например, секс с VR-аватаром или роботизированной копией человека без его (виртуального аватара) согласия; взлом беспилотного транспортного средства с целью угона, похищения или убийства его пассажиров; взлом секс-робота с целью убийства его владельца…

«Драматизм положения современного человека в том, что он окружает себя средой, в которой как целостное существо жить не (с)может: микро-, мега-, нано-, виртуизмерения несоразмерны его сначала телесному, а потом и духовному бытию, – комментирует эти тенденции профессор Нижегородского государственного университета им. Н.И. Лобачевского, доктор философских наук Владимир Кутырев. – В этом суть экологического и антропологического кризиса, перерастающего в вялотекущий апокалипсис, который ускоряется, ведя наш род к катастрофе через перерождение в форму, более адекватную техногенной реальности». Появляющийся вид Homo sapiens Владимир Кутырев называет «не люди – техноиды». И место техноидам – на других планетах.

Вывод профессора Кутырева: «Упорная работа над созданием Искусственного интеллекта, то есть безжизненного Разума – это финишная прямая в движении Homo vitae sapiens по пути Mortido («Позитивной смерти») как проявление Last am Untergang (нем.) – «Жажды собственной гибели».

Возможно, это предельный случай антропоконсерватизма… Существуют и другие точки зрения на проблему взаимодействия Homo sapiens с ИИ. Не менее, впрочем, радикальные. «Высшие психические функции не реализуются в автоматическом режиме. Формализовать субъективный мир личности невозможно, – уверен специалист в области интеллектуальных систем в гуманитарной сфере, доктор технических наук, профессор Российского государственного гуманитарного университета Виктор Финн. – Невозможна автоматизация интуиции».

Но как бы там ни было, для обывателя хорошо бы иметь «инструкцию по эксплуатации ИИ». (Хотя кто кого эксплуатирует в этой паре – вопрос уже сечас философский.) Но это было бы слишком просто и, главное, нетолерантно по отношению к ИИ. Не зря же в упомянутом выше проекте Еврокомиссии по отношению к кибернетическим системам применен политкорректный термин – «благонадежный искусственный интеллект».

Тот же Владимир Кутырев по поводу перспектив будущего мирового устройства и места (био)человека в нем предельно пессимистичен: «Субстрат субстанции роботов».

Но пока еще этот «субстрат» способен самоидентифицировать себя как нечто биологическое. Одним из проявлений этого процесса, пожалуй, можно считать бурный рост числа исследований в области нейроэтики. «Впрочем, впервые понятие нейроэтики было введено американским (нейро)психиатром и (нейро)психологом немецкого происхождения Эннелиз Алмой Понтиус еще 1973 году, – отмечает доктор философских наук, профессор Валентин Бажанов в своей книге «Мозг – Культура – Социум» (М., 2019). – Однако реальные исследования в сфере нейроэтики стали возможными лишь сравнительно недавно – примерно с начала XXI века…»

Центральный вопрос нейроэтики – выяснить, «каким образом активность тех или иных разделов мозга может влиять на моральные установки и решения человека». И даже еще радикальнее – «как особенности строения церебральных структур определяют те или иные элементы нравственности».

Нейроэтика как ответ неполиткорректных, консервативных представителей вида Homo sapiens на экспансию киберэтики. Чья этика окажется «этичнее», сложнее по своему устройству, или возникнет некий новый гибрид – нейрокиберэтика, – все это станет ясно уже в ближайшее время.

комментарии(0)